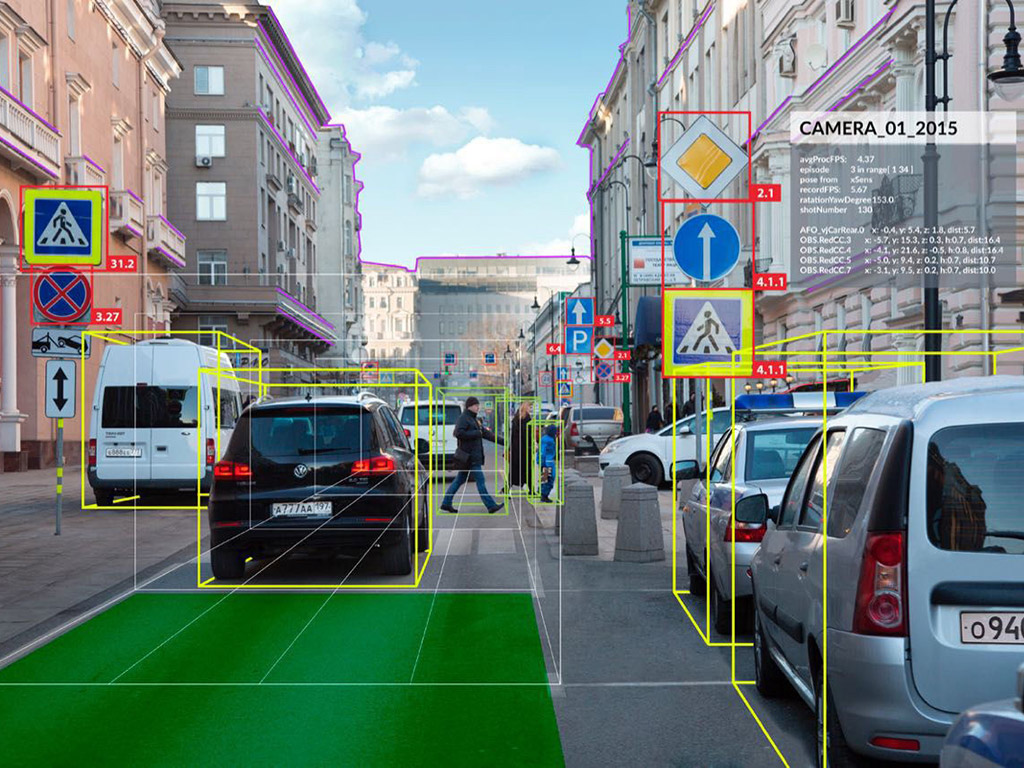

La vision par ordinateur analyse les images acquises par une ou plusieurs caméras afin d’extraire des informations sur la scène filmée telles que la reconstruction 3D, la localisation des caméras, la reconnaissance d’objets...

Elle a pour objectif de donner une intelligence au système d’acquisition se rapprochant de la vision humaine.

Cette discipline apparait véritablement en 1963 avec les travaux de thèse de Lawrence Roberts[1] dans lesquels il décrit comment extraire la forme 3D d’un solide à partir d’images 2D. Il s’ensuit un réel enthousiasme vers la recherche d’un système expert imitant la vision humaine pour lequel les efforts furent rapidement vains au regard de la technologie de l’époque [2].

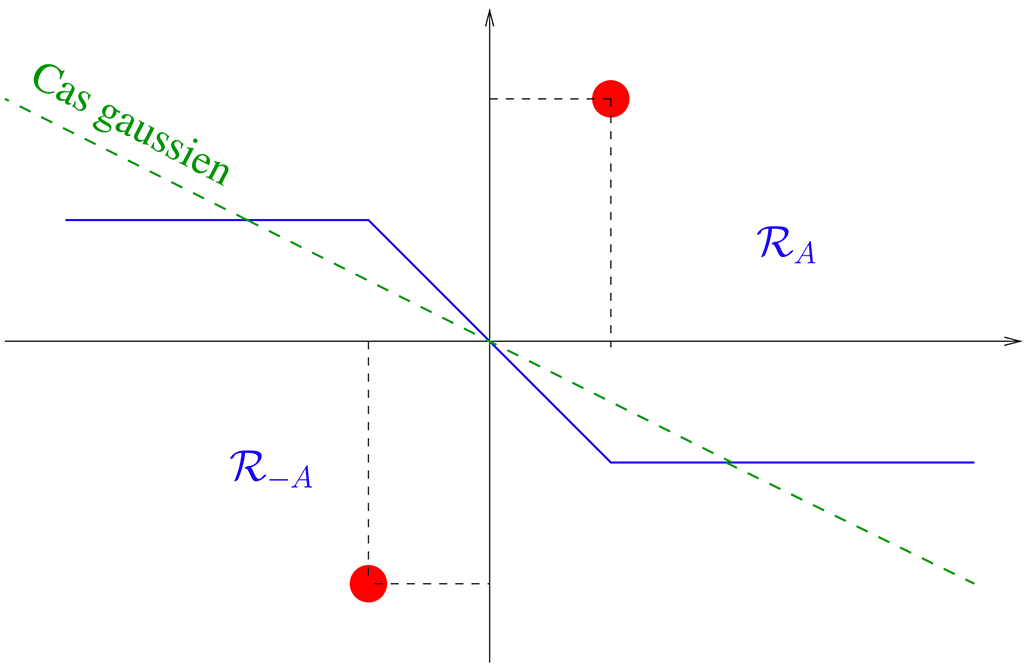

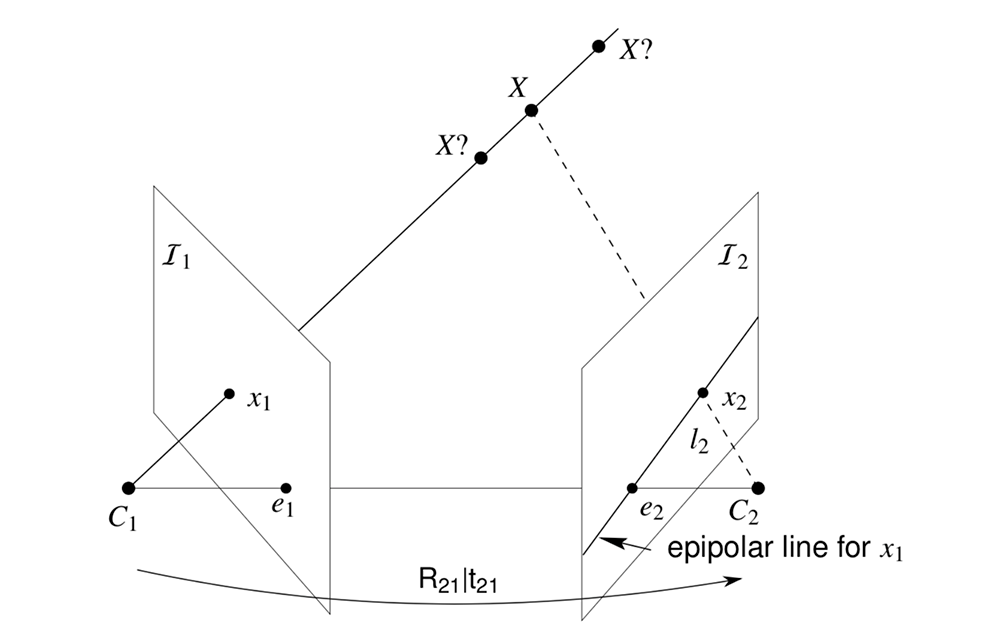

En 1980, David Marr formalise le premier détecteur de contours [3] puis élabore un paradigme de traitement et de représentation de l’information visuelle [4]. Cette décennie a permis de faire entrer la vision par ordinateur dans le monde de l’industrie et de la robotique mobile [5] notamment grâce aux travaux fondateurs sur la vision géométrique [6] (Fig 1), le flux optique [7] (eq 1) et le suivi de points [8]. On redécouvre alors les principes de la géométrie perspective décrits par Leon Battista Alberti au 15ème siècle bien avant la première photographie prise par Nicéphore Niepce en 1827.

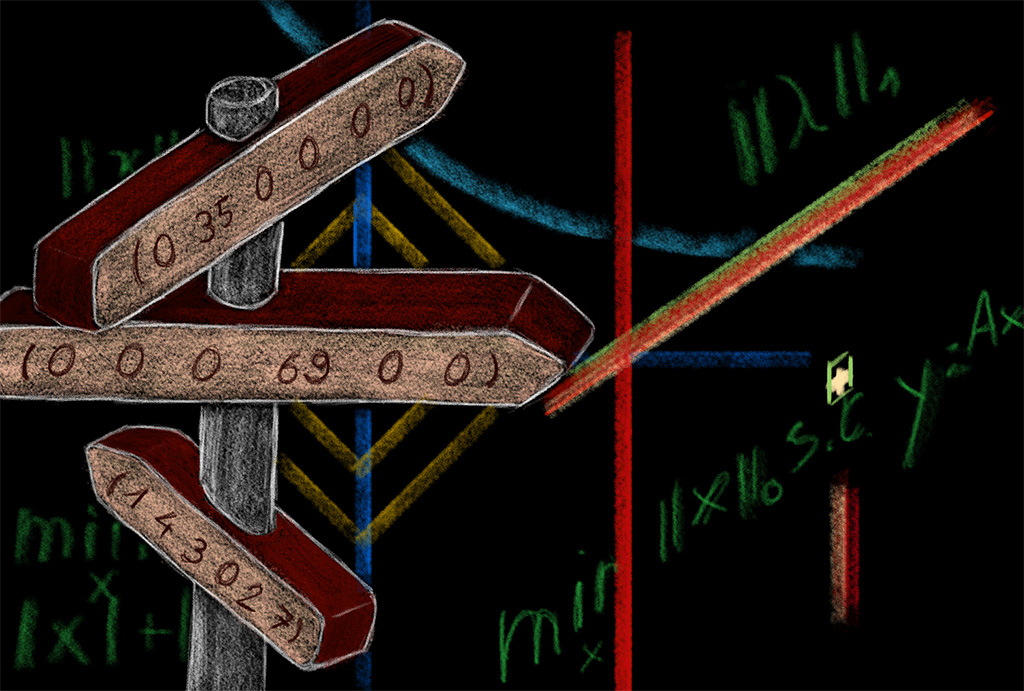

En 1989, Yann Le Cun présente ses premiers travaux [9] sur la reconnaissance de caractères à l’aide de réseau connexionniste sans que celui-ci soit véritablement remarqué à l’époque. Les années 90 sont considérées comme l’âge d’or de la géométrie pour la reconstruction 3D à l’aide d’images. Les chercheurs s’intéressent à l’étalonnage de caméras pour trouver précisément le projeté d’un point 3D de la scène sur le plan image [10], l’asservissement visuel pour guider une caméra vers une position désirée [11], la localisation de caméras qui par dualité permet de reconstruire la géométrie d’une scène [12]. Tous ces travaux nécessitent d’extraire des caractéristiques pertinentes dans les images. Pour ce faire, les chercheurs utilisaient principalement le détecteur de Harris [13] qui fut supplanté en 2004 par les SIFT (Scale-Invariant Feature Transform) [14] plus robuste à l’échelle.

C’est ainsi que les années 2000 ont permis d’amplifier les travaux en vision par ordinateur vers une reconstruction 3D de plus en plus fidèle grâce aux approches d’estimation de la structure à l’aide du mouvement dite Structure From Motion qui ont été largement étudiées lors de cette décennie [15,16]. La méthode proposée par Furukawa et Ponce [17] reste aujourd’hui encore l’une des techniques les plus précises (Fig 2).

![Reconstruction 3D à partir d’une série d’images – illustration tirée de [17]](/build/images/hist/vision-fig-02.dc35e4e8.png)

Tous ces travaux ont ainsi permis de montrer qu’il était possible de reconstruire la géométrie 3D une scène à partir d’images 2D.

L’arrivée en 2010 de nouvelles caméras permettant d’acquérir à la fois une image 2D et la profondeur de la scène (caméras RGBD telle la Kinect de Microsoft) a largement simplifié les problèmes de localisation, de reconstruction de scènes ou de détection d’obstacles. Néanmoins, l’analyse et l’interprétation d’une scène reste un sujet en plein essor.

Les travaux [9] ont trouvé un nouvel éveil grâce à ALexNet [18] qui a développé un réseau de neuronal convolutif améliorant très nettement la reconnaissance d’objets dans la base ImageNet. Depuis, la communauté s’intéresse très fortement aux techniques d’apprentissage profond afin de conférer une intelligence artificielle aux systèmes d’acquisition et résoudre le Summer Project [2] donné en 1966 où l’on pensait à l’époque qu’il suffisait d’un été pour décrire « ce que voyait une caméra ».

Références

[1] L. Robert. Machine Perception of Three-Dimensional Solids. Thèse de Doctorat,

Massachusetts Institute of Technology, 1963.

[2] S. Papert. The Summer vision project. Massachusetts Institute of Technology,

1966.

[3] D. Marr et E. Hildreth. Theory of Edge Detection. Proc. R. Soc. London, B 207,

187-217, 1980.

[4] D. Marr. Vision. W.H. Freeman, San-Francisco, 1982.

[5] B. P. Horn. Robot Vision. Massachusetts Institute of Technology press, 1986.

[6] H.C. Longuet-Higgins. A Computer Algorithm for Reconstructing a Scene from Two

Projections. Nature, Vol. 293, pp. 133–135, 1981.

[7] B. P. Horn et B.G. Schunck. Determining optical flow. Artificial intelligence,

17(1-3), 185-203, 1981.

[8] B. Lucas et T. Kanade. An iterative image registration technique with an

application to stereo vision. Proc. the International Joint Conference on Artificial

Intelligence, 1981.

[9] Y. LeCun, B. Boser, J.S. Denker, D. Henderson, R.E. Howard, W. Hubbard et L.D.

Jackel. Backpropagation applied to handwritten zip code recognition. Neural

computation, 1(4), 541-551, 1989.

[10] O. Faugeras. Three-dimensional computer vision: a geometric viewpoint. MIT

press. 1993.

[11] B. Espiau, F. Chaumette et P. Rives. A new approach to visual servoing in

robotics. IEEE Transactions on Robotics and Automation, 8(3), 313-326, 1992.

[12] L. Quan et Z. Lan. Linear n-point camera pose determination. IEEE Transactions

on pattern analysis and machine intelligence, 21(8), 774-780, 1999.

[13] C.G. Harris et M. Stephens. A combined corner and edge detector. In Alvey

vision conference Vol. 15, No. 50, pp. 10-5244, 1988.

[14] D.G Lowe. Distinctive image features from scale-invariant key points.

International Journal of Computer Vision, 60(2):91–110, 2004.

[15] M. Pollefeys, L. Van Gool, M.Vergauwen, F. Verbiest, K. Cornelis, J. Tops et R.

Koch. Visual modeling with a hand-held camera. International Journal of Computer

Vision 59(3), 207-232, 2004.

[16] A. J. Davison. Real-time simultaneous localisation and mapping with a single

camera. IEEE International Conference on Computer Vision, 2003.

[17] Y. Furukawa et J.Ponce. Accurate, dense, and robust multiview stereopsis. IEEE

transactions on pattern analysis and machine intelligence, 32(8), 1362-1376,

2009.

[18] A. Krizhevsky, I. Sutskever et G.E. Hinton. Imagenet classification with deep

convolutional neural networks. In Advances in neural information processing systems,

pp. 1097-1105, 2012